Як налаштувати Robots.txt правильно?

Правильний Robots txt для html сайту створює макети дії для роботів пошукових систем, повідомляючи їм, що вони можуть перевіряти. Часто цей файл згадується, як Протокол вилучення роботів. Перше, що шукають боти перед скануванням веб-сайту, - robots.txt. Він може вказувати на Sitemap або повідомляти йому, щоб він не перевіряв певні піддомени. Коли потрібно, щоб пошуковики шукали те, що найбільш часто зустрічається, то robots.txt не вимагається. Дуже важливо в цьому процесі, щоб файл був відформатований грамотно і не індексував власну сторінку з особистими даними користувача.

З іншого боку, якщо файл некоректно відформатовано, це може призвести до того, що сайт не буде показаний в результатах пошуку і його не знайдуть. Цей файл пошуковики обійти не можуть. Програміст може подивитися robots.txt будь-якого сайту, перейшовши в його домен і, слідуючи за ним з допомогою robots.txt наприклад, www.domain.com/robots.txt. Використовуючи такий інструмент, як розділ оптимізації SEO Unamo, в якому можна ввести будь-який домен, і сервіс покаже інформацію про наявність файлу. Обмеження для сканування: У користувача застарілий або конфіденційний контент. Зображення на сайті не включаться в результати пошуку зображень. Сайт ще не готовий до демонстрації, щоб робот індексував його. Потрібно мати на увазі, що інформація, яку користувач бажає отримати від пошуковика, доступна для всіх, хто вводить URL. Не варто використовувати цей текстовий файл для приховування конфіденційних даних. Якщо домен має помилку 404 (не знайдено) або 410 (минуло), пошукач перевіряє сайт, незважаючи на наявність robots.txt у цьому випадку він вважає, що файл відсутній. Інші помилки, такі як 500 (Internal Server Error), 403 (Forbidden), тайм-аут або «недоступний», враховують інструкції robots.txt проте обхід може бути відкладено до тих пір, поки файл не буде доступний.

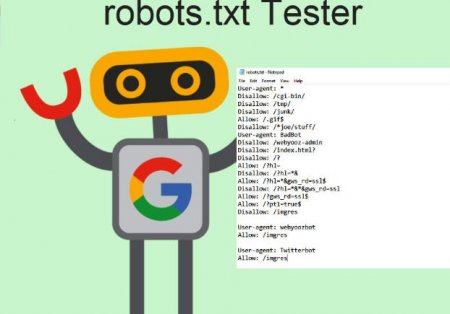

Основний формат правильного Robots txt для bitrix (Бітрікс): Легенда robots.txt. #, додаються коментарі, які використовуються тільки в якості нотаток. Ці коментарі будуть сканерами ігноруватися разом з будь-якими помилками користувача. User-agent - вказує, на якому пошуковику вказані інструкції для файлу. Додавання зірочки (*) повідомляє сканерів, що інструкції створені для всіх. Зазначення конкретного бота, приміром, Googlebot, Baiduspider, Applebot. Disallow, вказує сканерів, які частини веб-сайту не потрібно сканувати. Це виглядає так: User-agent: *. Зірочка означає «всі боти». Проте можна вказати сторінки для певних ботів. Для цього потрібно знати ім'я бота, для якого встановлюються рекомендації. Правильний robots txt для Яндекса може виглядати так: Якщо бот не повинен обходити сайт, можна вказати його, а щоб знайти імена агентів користувача, рекомендується ознайомитися з можливостями онлайн useragentstring.com.

Користувальницький агент:[имя пользователя агента]. Disallow:[URL строка, которая не сканируется]. У файлі кожен блок директив відображається як дискретний, розділений рядком. У файлі поряд з директорією користувача агента кожне правило використовується стосовно до конкретного набору розділених розділом рядків. Якщо файл має правило, що діє для кількох агентів, робот буде враховувати тільки найбільш конкретну групу інструкцій.

Google пропонує великий список можливого синтаксису завдання шаблонів, які роз'яснюють користувачеві, як правильно налаштувати файл Robots txt. Деякі поширені випадки використання включають: Запобігання появи повторюваного вмісту в результатах пошуку. Збереження всіх розділів веб-сайту в приватному порядку. Збереження внутрішніх сторінок результатів пошуку на основі відкритої виписки. Вказівка місця розташування. Запобігання пошукових систем індексування певних файлів. Вказівка затримки на обхід, щоб зупинити перевантаження, при одночасному скануванні кількох областей контенту.

Принцип сканування роботом

Коли пошукова система зустрічає файл і бачить заборонений URL адресу, вона не сканує його, але при цьому може проіндексувати його. Це пов'язано з тим, що навіть, якщо роботам не дозволено переглядати вміст, вони можуть запам'ятовувати зворотні посилання, що вказують на заборонений URL адресу. Через заблокованого доступу до посилання URL адреса з'явиться в пошукових системах, але без фрагментів. Якщо для вхідної маркетингової стратегії потрібно правильний Robots txt для bitrix (бітрікс) , забезпечують перевірку сайту за бажанням користувача сканерами.З іншого боку, якщо файл некоректно відформатовано, це може призвести до того, що сайт не буде показаний в результатах пошуку і його не знайдуть. Цей файл пошуковики обійти не можуть. Програміст може подивитися robots.txt будь-якого сайту, перейшовши в його домен і, слідуючи за ним з допомогою robots.txt наприклад, www.domain.com/robots.txt. Використовуючи такий інструмент, як розділ оптимізації SEO Unamo, в якому можна ввести будь-який домен, і сервіс покаже інформацію про наявність файлу. Обмеження для сканування: У користувача застарілий або конфіденційний контент. Зображення на сайті не включаться в результати пошуку зображень. Сайт ще не готовий до демонстрації, щоб робот індексував його. Потрібно мати на увазі, що інформація, яку користувач бажає отримати від пошуковика, доступна для всіх, хто вводить URL. Не варто використовувати цей текстовий файл для приховування конфіденційних даних. Якщо домен має помилку 404 (не знайдено) або 410 (минуло), пошукач перевіряє сайт, незважаючи на наявність robots.txt у цьому випадку він вважає, що файл відсутній. Інші помилки, такі як 500 (Internal Server Error), 403 (Forbidden), тайм-аут або «недоступний», враховують інструкції robots.txt проте обхід може бути відкладено до тих пір, поки файл не буде доступний.

Створення пошукового файлу

Багато програми CMS, такі, як WordPress, вже володіють файлом robots.txt. Перед тим, як правильно налаштувати Robots txt WordPress, користувачеві необхідно ознайомитися з його можливостями, щоб з'ясувати, як отримати до нього доступ. Якщо програміст самостійно створює файл, він повинен відповідати наступним умовам: Повинен бути написаний рядковими літерами. Використовувати кодування UTF-8. Зберігатися в текстовому редакторі файл (.txt). Коли користувач не знає, де його розмістити, він звертається до свого постачальника програмного забезпечення веб-сервера, щоб дізнатися, як отримати доступ до кореня домену або перейти в Google консолі і завантажити його. З допомогою цієї функції Google також можна перевірити, чи правильно бот функціонує, і перелік сайтів, які були заблоковані з використанням файлу.Основний формат правильного Robots txt для bitrix (Бітрікс): Легенда robots.txt. #, додаються коментарі, які використовуються тільки в якості нотаток. Ці коментарі будуть сканерами ігноруватися разом з будь-якими помилками користувача. User-agent - вказує, на якому пошуковику вказані інструкції для файлу. Додавання зірочки (*) повідомляє сканерів, що інструкції створені для всіх. Зазначення конкретного бота, приміром, Googlebot, Baiduspider, Applebot. Disallow, вказує сканерів, які частини веб-сайту не потрібно сканувати. Це виглядає так: User-agent: *. Зірочка означає «всі боти». Проте можна вказати сторінки для певних ботів. Для цього потрібно знати ім'я бота, для якого встановлюються рекомендації. Правильний robots txt для Яндекса може виглядати так: Якщо бот не повинен обходити сайт, можна вказати його, а щоб знайти імена агентів користувача, рекомендується ознайомитися з можливостями онлайн useragentstring.com.

Оптимізація сторінок

Дві такі рядки вважаються повним файлом robots.txt при цьому один файл роботів може містити декілька рядків користувальницьких агентів і директив, які забороняють або дозволяють сканування. Основний формат правильного Robots txt:Користувальницький агент:[имя пользователя агента]. Disallow:[URL строка, которая не сканируется]. У файлі кожен блок директив відображається як дискретний, розділений рядком. У файлі поряд з директорією користувача агента кожне правило використовується стосовно до конкретного набору розділених розділом рядків. Якщо файл має правило, що діє для кількох агентів, робот буде враховувати тільки найбільш конкретну групу інструкцій.

Технічний синтаксис

Його можна розглядати, як «мова» файлів robots.txt. Є п'ять термінів, які можуть існувати в цьому форматі, основні включають: User-agent - веб шукач з інструкцією обходу, зазвичай це пошуковик. Disallow - команда, що використовується для вказівки користувачеві агенту необхода (пропуску) певного URL адреси. Для кожного є виключно одне заборонене умова. Дозволити. Для Googlebot, який отримує доступ, навіть користувацька сторінка заборонена. Crawl-delay – вказує, скільки секунд знадобиться сканера перед обходом. Коли bot не підтверджує її, швидкість встановлюється в Google консолі. Sitemap – застосовують для визначення розташування будь-яких XML-карт, пов'язаних з URL.Зіставлення моделей

Коли справа доходить до фактичних URL блокувань або дозволів правильного Robots txt, операції можуть бути досить складними, оскільки вони дозволяють використовувати зіставлення шаблонів для охоплення ряду можливих параметрів URL. Google і Bing обидва використовують два символи, які ідентифікують сторінки або підпапки, які SEO хоче виключити. Цими двома символами є зірочка (*) і знак долара ($), де: * - це знак підстановки, який представляє будь-яку послідовність символів. $ - відповідає кінця URL-адреси.Google пропонує великий список можливого синтаксису завдання шаблонів, які роз'яснюють користувачеві, як правильно налаштувати файл Robots txt. Деякі поширені випадки використання включають: Запобігання появи повторюваного вмісту в результатах пошуку. Збереження всіх розділів веб-сайту в приватному порядку. Збереження внутрішніх сторінок результатів пошуку на основі відкритої виписки. Вказівка місця розташування. Запобігання пошукових систем індексування певних файлів. Вказівка затримки на обхід, щоб зупинити перевантаження, при одночасному скануванні кількох областей контенту.

Перевірка наявності робото-файлу

Якщо на сайті немає зон, які потрібно сканувати, то robots.txt взагалі не знадобиться. Якщо користувач не впевнений, що є цей файл, йому необхідно ввести в кореневий домен і набрати його в кінець URL, приблизно так: moz.com/robots.txt. Ряд пошукових ботів ігнорують ці файли. Однак, як правило, ці сканери не належать до авторитетним пошуковикам. Вони з роду спамерів, поштових агрегатів та інших типів автоматизованих ботів, які у великій кількості розміщені в Інтернеті. Дуже важливо пам'ятати, що використання стандарту виключення роботів не є ефективним заходом безпеки. Фактично деякі боти можуть починатися зі сторінок, на яких користувач задає їм режим сканування. Є кілька частин, які входять в стандартний файл виключення. Перш ніж розповісти роботу, на яких сторінках він не повинен працювати, потрібно вказати, з яким роботом розмовляти. У більшості випадків користувач буде використовувати просту декларацію, яка означає «всі боти».Оптимізація SEO

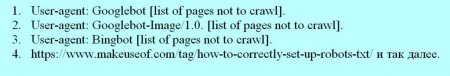

Перед оптимізацією користувач повинен переконатися, що не блокує будь-який контент або розділи сайту, які треба обійти. Посилання на сторінки, заблоковані правильним Robots txt, не будуть дотримані. Це означає: Якщо вони не пов'язані з іншими сторінками, доступними для пошукових систем тобто сторінки, не заблоковані за допомогою robots.txt або мета-робота, а пов'язані ресурси не будуть скануватися і тому не можуть бути проіндексовані. Ніяка посилання не може бути передана із заблокованої сторінки в пункт призначення посилання. Якщо є така сторінка, краще використовувати інший механізм блокування, відмінний від robots.txt. Оскільки інші сторінки можуть безпосередньо посилатися на сторінку, яка містить особисту інформацію і потрібно заблокувати цю сторінку з результатів пошуку, використовують інший метод, наприклад, захист паролем або мета дані noindex. Деякі пошукові системи мають кілька користувальницьких агентів. Наприклад, Google використовує Googlebot для звичайного пошуку і Googlebot-Image для пошуку зображень. Більшість користувацьких агентів з однієї і тієї ж пошукової системи слідують тим же правилам, тому немає необхідності вказувати директиви для кожного з кількох пошукових роботів, але, маючи можливість зробити це, можна точно настроїти перевірку вмісту сайту. Пошукова система кешує вміст файлу і зазвичай оновлює вміст кешування не рідше одного разу в день. Якщо користувач змінить файл і хоче оновити його швидше, ніж це відбувається стандартно, він може відправити URL robots.txt в Google.Пошукові системи

Щоб зрозуміти, як працює Robots txt правильно, потрібно знати про можливості пошукових систем. Коротко, їх можливості полягають у тому, що вони відправляють «сканери», які являють собою програми, які переглядають Інтернет для отримання інформації. Потім вони зберігають частину цієї інформації, щоб згодом передати її користувачеві. Для багатьох людей Google - це вже Інтернет. По суті, вони мають рацію, оскільки це, можливо, найважливіше його винахід. І хоча пошукові системи сильно змінилися з моменту створення, основні принципи їх все ті ж. Сканери, також відомі як «боти» або «павуки», знаходять сторінку з мільярдів веб-сайтів. Пошукові системи дають їм вказівки про те, куди йти, при цьому окремі сайти також можуть спілкуватися з ботами і повідомляти їм, на яких конкретних сторінках вони повинні дивитися. Як правило, власники сайтів не хочуть показувати у пошукових системах: адміністративні сторінки, бекенда-портали, категорії і теги, а також інші інформаційні сторінки. Файл robots.txt також можна використовувати, щоб пошуковики не перевіряли сторінки. Коротше кажучи, robots.txt повідомляє веб-сканерів, що робити.Заборона сторінок

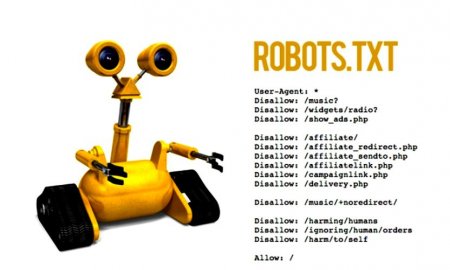

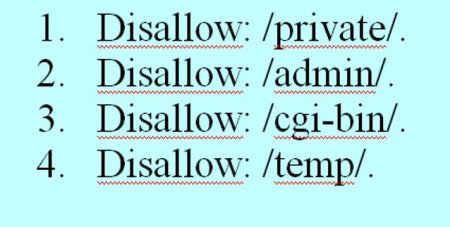

Це основна частина файлу виключення роботів. За допомогою простого оголошення користувач вказує боту або групі ботів, щоб вони не сканували певні сторінки. Синтаксис простий, наприклад, для заборони доступу до всього в директорії «admin» сайту пишеться: Disallow: /admin. Цей рядок не дозволить ботам сканувати сайти yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html і все інше, що потрапляє під каталог адміністратора. Щоб заборонити одну сторінку, просто вказують її в рядку заборони: Disallow: /public/exception.html. Тепер сторінка «виняток» не буде перенесена, але все інше в «загальнодоступної» папки. Щоб включити кілька сторінок, просто перераховують їх: Ці чотири рядки правильного Robots txt для symphony будуть застосовуватися до будь-якого користувача агенту, вказаною у верхній частині розділу # robots.txt для https://www.symphonyspace.org/. Карта сайту: https://www.symphonyspace.org/sitemaps/1/sitemap.xml. Інші команди: # live - не дозволяти веб-сканерів індексувати cpresources/або постачальника/. Користувальницький агент: * Disallow: /cpresources /. Заборонити: /виробника /Disallow: /.env.Налаштування стандартів

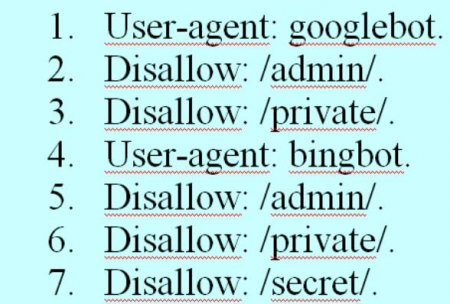

Користувач може вказати певні сторінки для різних ботів, об'єднавши попередні два елемента, ось як це виглядає. Приклад правильного Robots txt для всіх пошукачів представлений нижче. Секції «admin» і «private» невидимі для Google і Bing, але Google все ж побачить «секретний» каталог, в той час як Bing цього не зробить. Можна вказати загальні правила для всіх ботів, використовуючи користувальницький агент asterisk, а потім дати конкретні інструкції ботам в наступних розділах. Зі знанням вище користувач може написати приклад правильного Robots txt для всіх пошуковиків. Просто запустити свій улюблений текстовий редактор і повідомити ботам, що їх не вітають у певних частинах сайту.Поради з підвищення продуктивності сервера

SublimeText - це універсальний текстовий редактор і золотий стандарт для багатьох програмістів. Його програмні поради засновані на ефективному кодуванні, крім того. користувачі цінують у програмі наявність швидких клавіш. Якщо користувач хоче побачити приклад файлу robots.txt потрібно перейти на будь-який сайт і додати «/robots.txt» кінець. Ось частина файлу robots.txt GiantBicycles. Програма забезпечує створення сторінок, які користувачі не хочуть показувати в пошукових системах. І також має кілька ексклюзивних речей, про які мало кому відомо. Наприклад, якщо файл robots.txt повідомляє ботам, куди не треба йти, файл Sitemap робить все навпаки і допомагає їм знаходити те, що вони шукають, і хоча пошуковики, ймовірно, вже знають, де розташована карта сайту, не заважає їм. Існує два типи файлів: HTML сторінка або XML-файл. HTML-сторінка - це та, яка показує відвідувачам всі наявні сторінки на сайті. У власному robots.txt він виглядає так: Sitemap: //www.makeuseof.com/sitemap_index.xml. Якщо сайт не індексується пошуковими системами, хоча він кілька разів сканувався веб-роботами, потрібно переконатися, що файл є і що його дозволу встановлені правильно. За замовчуванням це буде відбуватися з усіма установками SeoToaster, але в разі потреби можна скинути його наступним чином: File robots.txt – 644. Залежно від PHP-сервера, якщо це не працює для користувача, рекомендується спробувати наступне: File robots.txt – 666.Установка затримки сканування

Директива про затримку обходу повідомляє певним пошуковим системам, як часто вони можуть індексувати сторінку на сайті. Вона вимірюється в секундах, хоча деякі пошукові системи інтерпретують її дещо інакше. Деякі бачать затримку обходу 5 коли говорять їм почекати п'ять секунд після кожного сканування, щоб почати наступне. Інші інтерпретують це, як інструкцію сканувати тільки одну сторінку кожні п'ять секунд. Робот не може сканувати швидше, щоб зберегти пропускну здатність сервера. Якщо сервер повинен відповідати трафіку, він може встановити затримку обходу. Загалом, В більшості випадків, користувачам не потрібно турбуватися про це. Ось так встановлюється затримка обходу восьми секунд - Crawl-delay: 8. Але не всі пошукові системи будуть підкорятися цій директиві, тому при забороні сторінок, можна встановити різні затримки сканування для певних пошукових систем. Після того, як всі інструкції у файлі налаштовані, можна завантажити на сайті, попередньо переконатися, що це простий текстовий файл і має ім'я robots.txt і його можна знайти за адресою yoursite.com/robots.txt.Кращий бот WordPress

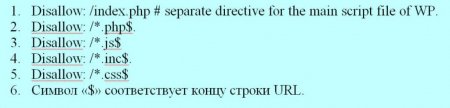

На сайті WordPress є деякі файли і каталоги, які необхідно кожен раз блокувати. Каталоги, які користувачі повинні заборонити - це каталог cgi-bin стандартні каталоги WP. Деякі сервери не дозволяють доступ до каталогу cgi-bin, але користувачі повинні включити його в директиву disallow, перед тим як правильно налаштувати Robots txt WordPress Стандартними каталогами WordPress, які повинні заблокувати, є wp-admin, wp-content, wp-includes. У цих каталогах немає даних, які спочатку корисні для пошукових систем, але існує виключення, тобто в каталозі wp-content існує підкаталог з ім'ям uploads. Цей підкаталог повинен бути дозволений у файлі robot.txt, оскільки він включає все, що завантажується, використовуючи функцію завантаження WP media. WordPress використовує теги або категорії для структурування вмісту. Якщо категорії використовуються, то для того, щоб зробити правильний Robots txt для Wordpress, як зазначено виробником програми, необхідно заблокувати архіви тегів з пошуку. Спочатку перевіряють базу, зайшовши в панель «Адміністрування»> «Налаштування»> «Постійне посилання». За замовчуванням базою є тег, якщо поле пусте: Disallow: /tag /. Якщо використовується категорія, то необхідно заблокувати категорію в файлі robot.txt: Disallow: /category /. За замовчуванням базою є тег, якщо поле пусте: Disallow: /tag /. Якщо використовується категорію, то необхідно заблокувати категорію в файлі robot.txt: Disallow: /category /. Файли, які використовуються в основному для відображення вмісту, вони заблокуються правильним файлом Robots txt для Wordpress:Основна установка Joomla

Як тільки користувач встановив Joomla, потрібно переглянути правильну настройку Robots txt Joomla глобальної конфігурації, яка розташована на панелі управління. Деякі налаштування тут дуже важливі для SEO. Спочатку знаходять ім'я сайту і переконуються, що використовується коротке ім'я сайту. Потім знаходять групу налаштувань праворуч від екрану, який називається налаштуваннями SEO. Той, який точно доведеться змінити, є другим: використовувати URL-адресу перезапису. Це звучить складно, але в основному це допомагає Joomla створювати більш чисті URL-адреси. Найбільш помітно, якщо видалити рядок index.php з URL-адрес. Якщо змінити її пізніше, URL-адреси зміняться, і Google це не сподобається. Однак при зміні цього параметра необхідно зробити кілька кроків для створення правильного robots txt для Joomla: У кореневій папці Joomla знайти файл htaccess.txt. Позначити його як .htaccess (без розширення). Включити назву сайту в заголовки сторінок. Знайти налаштування метаданих в нижній частині екрана глобальної конфігурації.Робот в хмарі MODX

Раніше MODX Cloud надавав користувачам можливість контролювати поведінку дозволяє файлу robots.txt для обслуговування на основі перемикання в панелі моніторингу. Хоча це було корисно, можна було випадково дозволити індексування на сайтах staging/dev, переключивши опцію в Dashboard. Аналогічним чином можна було легко заборонити індексування на виробничому майданчику. Сьогодні сервіс вважає присутність файлів robots.txt у файловій системі з наступним виключенням: будь-домен, який закінчується, modxcloud.com буде служити Disallow: /директивою для всіх користувальницьких агентів, незалежно від наявності або відсутності файлу. Для виробничих майданчиків, які отримують реальний трафік відвідувачів, потрібно буде використовувати власний домен, якщо користувач хоче проіндексувати свій сайт. Деякі організації використовують правильний Robots txt для modx для запуску декількох вебсайтів з однієї установки з використанням Contexts. Випадком, в якій це може бути застосовано, буде публічний маркетинговий сайт в поєднанні з мікро сайтами цільової сторінки і, можливо, непублічної інтрамережі. Традиційно це було складно зробити для багатокористувацьких установок, оскільки вони розділяють один і той же корінь мережі. В MODX Cloud виконати це легко. Просто завантажують додатковий файл на веб-сайт, названий robots-intranet.example.com.txt таким контентом, і він заблокує індексування за допомогою добре працюють роботів, а всі інші імена хостів повернуться до стандартних файлів, якщо не існує інших конкретних іменних вузлів. Robots.txt є важливим файлом, який допомагає користувачеві посилатися на сайт в Google, основних пошукових системах і інших вебсайтах. Розташований у корені веб-сервера - файл інструктує веб-роботів для сканування сайту, встановлює якісь папки він повинен або не повинен індексувати, з допомогою набору інструкцій, називаних Протоколом вилучення роботів. Приклад правильного Robots txt для всіх пошукачів obots.txt особливо просто виконується з допомогою SeoToaster. Для нього створено спеціальне меню в панелі керування, тому боту ніколи не доведеться перенапружуватися для отримання доступу.Цікаво по темі

Індексація сайту в пошукових системах: підготовка, перевірка і прискорення

Індексація сайту в пошукових системах – процес обробки веб-ресурсу та занесення відомостей, отриманих з нього, в спеціальну базу даних,

Основні HTML meta-теги: опис

Теги в HTML розташовуються усередині тега і дуже важливі для ранжирування веб-сторінки в пошукових системах.

Як перевірити і прискорити індексацію в "Яндексі"?

Додаючи контент на сайті, кожен вебмайстер сподівається, що всі оновлення швидко потраплять в індекс пошуковиків, адже саме від цього багато в чому

Robots.txt Disallow: як створити, особливості та рекомендації

Потрапляючи на курси з SEO-просування, новачки зустрічаються з великою кількістю зрозумілих і не дуже термінів. У всьому цьому розібратися не так вже

Як створити Sitemap: докладна інструкція для оптимізатора

Чому багато оптимізаторів в першу чергу перевіряють наявність і структуру карти сайту? Справа в тому...

Індексація сайту в пошукових системах. Як відбувається індексування сайту в "Яндекс" і "Гугл"

Ви бажаєте, щоб ваш сайт відображався у запитах результатів пошуковиків? Тоді він повинен бути оброблений пошуковими системами «Рамблер», «Яндекс»,